(このブログは「気候変動社会の技術史」(日本評論社)の公式解説ブログの一部です)

パラメタリゼーション

ここでは気候モデルという言葉を用いているが、この問題は、大循環モデルも地球システムモデルでも同じである。

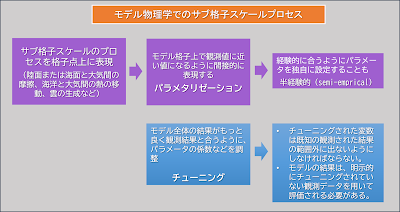

「モデル物理学」には、大気中で発生するすべての主要な物理プロセスが含まれる。例えば、これらのプロセスの多くは熱の伝達を伴っている。しかも、実際の大気ではこれらのプロセスは通常はモデル格子よりもはるかに小さく、究極的には分子スケールで起こるものもある。このようなプロセスをモデル格子上で直接表現することはできない。モデル作成者(モデラー)は、このようなモデル格子より小さなプロセスを「サブ格子スケール」プロセスと呼ぶ。

モデラーは、このような小規模な物理プロセス、例えば陸面または海面と大気間の摩擦、海洋と大気間の熱の移動、雲の生成などを直接モデル化せずに、その大規模な効果だけを反映する数学関数や定数を使用してモデル格子内で表現する。これがパラメタリゼーションである。これによって、モデル格子間隔では直接表現できないプロセスによる物理変数を、モデル格子上で観測値に近い値になるように間接的に表現する。

積雲対流の影響をパラメタリゼーションで格子点上で現す場合の模式図

例えば、個々の積雲が下層で風(緑)を集めて上層へ熱(橙)を移送し水分(青)を落下させる。これらのプロセスによる総体的影響を、何らかパラメタリゼーションを用いて格子点上の値(実線矢印)として表す。模式図は実際の積雲の物理を示しているものではない。

そもそも米国気象学会によると、パラメータとは、問題を処理できるように任意に値を割り当てることができる量を指す。これは、直接モデル化することはできないプロセスを、推定するあるいは推察することができるようにするものである。そして、それらのパラメータをモデル内に導入することを、パラメタリゼーションと呼ぶことがある。

あるプロセスをパラメタリゼーションで表す場合、モデラーは、観測値の範囲を確認しながら、そのプロセスとモデル内で用いている格子点の独立変数との間に関係を見出そうとする。そのような関係を見出すことに成功した場合、その結果得られたパラメータを「物理ベース」と呼ぶ。しかし、格子点を代表する物理変数との直接的な関連性を見出せないこともしばしばある。このような場合、モデラーはその場限りの手法を考案して、モデルに導入することもある。

本書では、パラメタリゼーションの例として、降雨のプロセス、大気での放射伝達での分光パラメータの例を挙げている。通常、モデル物理には、何百、何千ものパラメタリゼーションが含まれている。モデルの最終的な出力は、すべてのパラメタリゼーション間の相互作用と、それらのモデルの力学との相互作用に依存する。これらの相互作用は非常に複雑であるため、モデルの結果がなぜそうなるのかを、物理学的に判断することは、困難なことが多い。

そのため、気候学者のスティーブン・シュナイダーらは、これらのパラメータを「半経験的(semi-emprical)」と呼んだ。著者によると、この呼び方はパラメータと観測データとの関係があいまいであることを強調する適切な表現としている。

気候のモデル化において、現実のサブ格子スケールの物理プロセスを、パラメタリゼーションを用いて完全に表現することは難しい。このため、パラメタリゼーションは、科学論争および政治論争の原因となっている。

チューニング

「チューニング」とは、パラメタリゼーションにおいて、モデル全体の結果をもっと良く観測結果と合うように、パラメータの係数の値を調整したり関係式を再構築したりすることを意味する。パラメータは他のパラメータと強く相互作用するため、あるパラメータを変更すると、ほかのパラメータの挙動が許容範囲外になり、さらなるチューニングが必要になることもある。

一般的に、モデラーはチューニングを必要悪と見なしている。多くのモデラーは、チューニングにおいてある種の制約を守ろうとしている。例えばチューニングによって、チューニングされた変数は既知の観測された結果の範囲外に出ないようにしなければならない。また、モデルの結果は、明示的にチューニングされていない観測データを用いて評価される必要がある。

パラメタリゼーションとチューニングの考え方

.jpg)