(このブログは「気候変動社会の技術史」(日本評論社)の公式解説ブログの一部です)

前回同様に、ここでは気候モデルという言葉を用いているが、この問題は大循環モデルも地球システムモデルでも同じである。

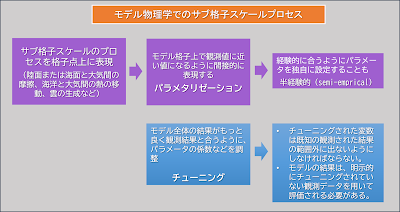

1980 年代にモデルが現実の気候の振る舞いを、高い信頼性を持ちある程度の正確さで捉えることができることを示すには、基本的に2 つの方法があった。一つの方法は、モデルのパラメータ値を現在に近い状態に設定し、20~100 年間のシミュレーションを実行して気候を求め、その結果を現実の大気循環の統計値と比較することである。

もう1 つは、最終氷期や高温の白亜紀のような現在と異なる条件にパラメータを設定する方法である。もしモデルの結果が古生物学的に推定された過去の気候条件とほぼ同じであれば、モデルの性能に対する信頼が高まる。そして、このモデルのパラメータを現在の状態に合わせれば、シミュレーションが正確である可能性が高くなる。

しかし、モデルの結果を実際の気候と比較して、両者が似ていればモデルの結果が常に信頼できるか?という議論は簡単ではない。例えば、科学史家であるナオミ・オレスケスは、モデルの結果は本質的に複雑な帰納的議論であると主張している。帰納的命題は完全に確実に証明することができないため、厳密な意味ではモデルの性能を実証することはできない。それは、モデルで与えた条件で現実に近い状態が再現できても、その現実に近い条件がモデルで与えた条件でなければ出現しない、ということを立証することが出来ないからである。

しかし、そのようなモデルが科学的論理で完全に立証されたと言えなくても、モデルの結果は「有効」である可能性は高い。そのため、オレスケスらは、そのようなモデルの結果は少なくとも「確認された(confirmed)」ものであると主張している。

この見解は、科学的仮説(あるいはモデル結果)は、観測によって誤りであることを証明することはできるが真理であることを証明することはできない、とする科学哲学者カール・ポパーのよく知られた反証主義の教義と一致する。

そのため、IPCCの評価報告書では、モデルと現実との間の対応の一致度の判定として、「評価(evaluation)」という言葉を用いている。

モデルの信頼度を表すのに別のやり方がある。それはモデル同士の相互比較である。大気モデル相互比較プロジェクト(AMIP)は、これらのプロジェクトの中でも最初のものだった。このプロジェクトは、1989 年にローレンス・リバモア国立研究所で組織された。AMIP が取った戦略は、各モデルグループに対する特定の「境界条件」またはパラメータを用いたモデル実行の要請だった。その上、すべてのモデルの実行結果は、特定の出力変数を標準様式で提供することが要求された。

モデルを異なる条件で動かして異なる様式で出力させると、結果を比較することは困難である。しかし、この共通仕様による各モデルの気候計算により、モデルの性能を相互に比較して、モデルの動作の違いの原因を診断するための基盤が構築された。

このAMIP の後、相互比較はより入念な一連のプロジェクトへと発展していった。例えば、結合モデル相互比較プロジェクト(CMIP)では、さまざまな共通条件の下で、結合モデルのシミュレーション結果が比較されている。

著者によると、このモデルの相互比較はさまざまなモデルやモデルグループをつなぐ標準化されたゲートウェイとして機能する(ゲートウェイについては「インフラストラクチャとしての気候知識(3)」を参照)。モデル同士や標準化された観測に基づくデータセットとの定期的で直接的、かつ有意義な比較を可能にしたことで、これは気候モデル作成を、個々の研究所の技術的活動からほぼすべての世界の気候モデルグループが関わる共通化および標準化された集団的活動へと変貌させることに貢献した。そして、それらの結果はIPCCに反映されている。

図 SPM.1 世界平均気温の変化の歴史と最近の温暖化の要因(AR6第 1 作業部会報告書 政策決定者向け要約より)

過去

170 年間の世界平均気温の変化(黒色の線)。1850~1900 年を基準とした年平均値を、第

6 期結合モデル相互比較プロジェクト(CMIP6)気候モデルによるシミュレーションから得られた人為起源と自然起源の両方の駆動要因を考慮した気温(茶色)及び自然起源の駆動要因(太陽及び火山活動)のみを考慮した気温(緑色)と比較している。各色の実線は複数モデルの平均値、着色域はシミュレーション結果の可能性が非常に高い範囲を示す。

例えばAR6の「政策決定者向け要約」には、気候の現状として次のように既述している。これにある気温幅は、CMIP6のモデル相互比較の結果から得られたものである。

1850~1900 年から 2010~2019 年11までの人為的な世界平均気温上昇の可能性が高い範囲は 0.8℃~1.3℃であり、最良推定値は 1.07℃である。よく混合された 温室効果ガスは 1.0℃~2.0℃の昇温に寄与し、他の人為起源の駆動要因(主にエーロゾル)は 0.0℃~0.8℃の降温に寄与し、自然起源の駆動要因は世界平均気温を-0.1℃~0.1℃変化させ、内部変動は-0.2℃~0.2℃変化させた可能性が高い。

例え現実に近い結果を出すモデルでも、1個だけだとその信頼性には限界がある。しかし、信頼性が確立された多数のモデルの結果を集めてその幅を示すことで、いろんな可能性を含めた結果の信頼性が増すとともに、その限界もわかるようになる。決定論的な結果でなくとも、その幅や限界がわかれば、それは人類の知として十分に機能する。

.jpg)